2019-01-31: 2700多词单词列表需要构词比对fake_words.7z (13.6 KB) :最简单的非人工处理方式思路:待剥离GoldenDict的核心部分(非UI相关的所有词典处理部分)出来,开发/完善命令行查词功能,以适配命令行工具(grep/awk等)对查询结果的批处理需求。

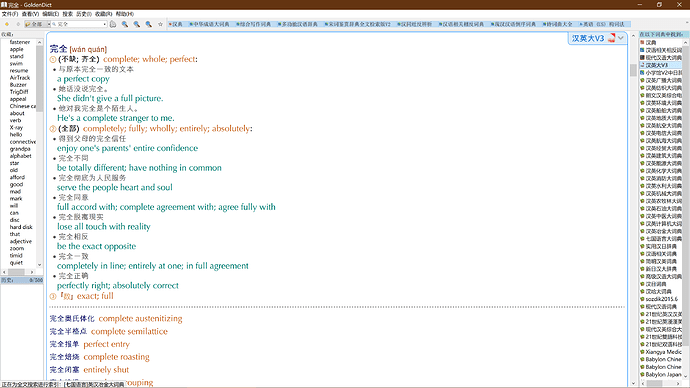

2019-01-29: 对剩余的2700多词,需要通过对汉英大进行全文搜索,整理出错词(fake_word可能的错词)对应的词头head word,通过这个head word去检索其它所有的汉英词典(以stardict格式金山数据的 词典为主),从检索到的词条内容中fake_word的拼写相近的单词来替代fake_word。

2019-01-28: 通过撞击bing在线词典又过滤去了一撮,剩余2700多词。

有空儿合了一版汉英大(数据为三版内容和二版部分内容),然而三版英文部分错别词较多,请问有什么方法(或有效可用的可用工具/库)能够自动校对或过滤文本中的错词呢?

只需要把其中的可能的错词挑选出来也行,较少的情况可以人工校正。