我说的就是在本地运行对文本的处理,API调用和翻译时电脑的卡顿无关。沉浸式翻译是可以在手机用的,没人会疯了去在用户的手机上运行大模型。

使用付费模型的话,总成本看看是不是能相对准确的预估一下。试过调用硅基流动的qwen模型翻译OED,相对价格较低的,随便一个词条,花了接近1块钱。上百万词条下来,感觉不便宜啊。

可以试试在0:30-8:30这段时间使用deepseekV3,有五折优惠。我至今还没见过有比这还便宜的(满血大模型)API。

下面是deepseek官方的token计算工具,至于翻译中实际的花费恐怕还是得实验一下才能准确估计。

deepseek_v3_tokenizer.zip (1.9 MB)

说的是沉浸式翻译免费模式下所用硅基流动API(免费模式下的谷歌翻译效果也不尽人意),收费模式肯定会有不同。

这个估算是怎么来的?使用免费还是收费资源?输入的文本大小有限制吗?如果使用收费模式,费用估算大概多少?

deepseek自己的测算(舍弃例句),未知依据所在,也不知是否幻觉。最终所有的实施方案都是要基于实测数据才准确。

这个信息还是很模糊,主要还是在于我经验太少。什么事都是经历过才明白。

可以咨询一下这部词典的制作者,就在本坛。另外,有软件开发或架构经验的可以参考一下前面提及的那篇博文我用 Claude Code 花 2 小时没写一行代码做了一个翻译智能体,并且开源了整个过程 | 宝玉的分享

晚点我也让deepseek分析评估一下(假装自己是个开发人员)。

用ds来翻词典是糟糕的选择,ds的幻觉一直都是最多的,堪称胡编大师。用4o 或gemini flash好点

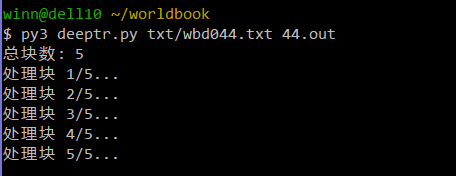

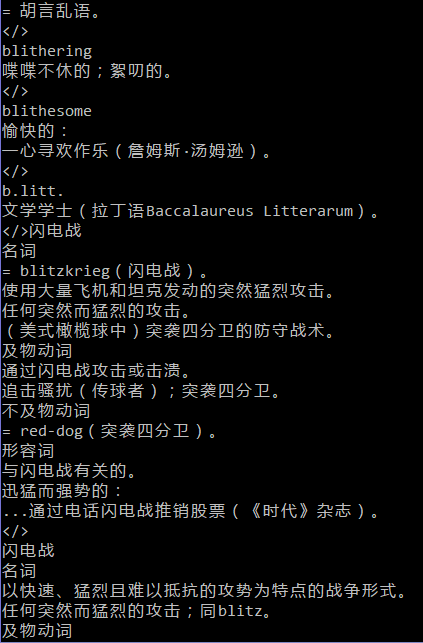

请教了制作 英和活用 的@Sunny1,得到使用 API 翻译的信息,测试成功,得到翻译文本。DS API 最大tokens 数为 8192,一个文件要分成很多块。以一个英文字节 0.5 tokens 保守计算,每块最大字节数是15k。其次用于测试的模型(v1)理解能力还赶不上网页版(提示词相同),译文输出无法保证与原文格式一致,讲明不译词头可还是译了。还要继续调试寻找一种高效可行的方式(调节文本等)。错峰时段提交,成本可控。

Deepseek-V1属于第一代产品,相较于后代模型有着相当的核心局限,所以你会很明显地感觉它理解能力不足的问题。以下就你提供的反馈信息及所遇其它问题,结合本人之前提交的项目可行研究的论证,重新让deepseek 做了解答,并提供了AI生成的可行方案,供参考。

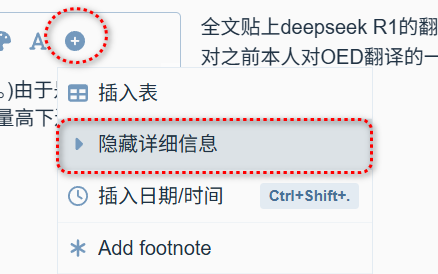

顺便说几句,以下全文贴出的基于deepseek R1官方app的分析中有少量引自本贴的相关讨论,但绝大部分源自各大技术专业网站内容(footnote有来源链接,有心人可以自行点击验证。参见网页搜索结果截图),个人认为其可信度和生成质量还是相当高的。与之对应,其它一些接入deepseek 最新模型的平台,比如文小言,其实是订制化的deepseek R1"满血版“,在模型推理能力、联网搜索机制及功能实现上跟原生版存在显著差异。以文小言为例,联网模式下搜索范围上依赖的是百度搜索生态,结果受SEO影响,加上受百度内容安全策略限制所做的信息过滤,在某些领域的生成内容及质量同deepseek官方模型(基于事实优先的权重算法)有着一眼可辨的区别。当然,对AGC内容优劣的评判从来都是见仁见智,各方观点分歧由来已久。本人的原则,有错可提、可辩,但不接受无证无据,怀私挟恨,诸如“通篇幻觉“,”又臭又长“的情绪化指责,若因此引来再一场无谓的口水之争实非本人所愿。

详情

以下是对OED人机协作翻译项目中用户winn技术实践的深度分析及优化建议,结合DeepSeek模型演进、翻译性能对比及大型词典项目的技术路径设计,分四部分系统阐述:

一、winn的API使用场景与技术瓶颈分析

-

API提供方推断

- 第三方中转平台可能性高:

winn提及“API最大tokens数为8192”,而DeepSeek-V1官方支持128K上下文(开源版),但第三方API平台常对免费用户施加8K tokens限制(如GPT-API-free等中转服务)。 - 成本控制需求:

“错峰时段提交,成本可控”表明其可能使用按量计费的中转API(如硅基流动),价格约为官方1/10,但存在功能阉割。

- 第三方中转平台可能性高:

-

模型版本定位

- DeepSeek-V1属于第一代产品(2024年1月发布),其核心局限包括:

- 仅支持基础Transformer架构,未引入MoE专家机制,长文档处理能力弱;

- 术语一致性差(如误译词头),文化适配性不足;

- 提示词遵循率低(格式错乱、忽略“不译词头”指令)。

- DeepSeek-V1属于第一代产品(2024年1月发布),其核心局限包括:

二、DeepSeek各代模型翻译能力横向对比

| 能力维度 | V1 (早期) | V3 (2024.12) | R1-0528 (2025.5) |

|---|---|---|---|

| 架构 | 稠密模型(67B) | 混合专家MoE(671B,激活37B) | 推理优化+RLHF对齐 |

| 上下文长度 | 128K (开源版) | 128K | 64K |

| 术语准确性 | 较低(MMLU-Pro≈65) | 极高(MMLU-Pro 81.2↑) | 高(GPQA 68.4↑) |

| 文化适配性 | 直译为主,缺乏本地化 | 中等 | 极强(AIME 87.5↑) |

| 提示遵循能力 | 弱(忽略格式/术语指令) | 中等 | 极强(思维链深度优化) |

| 长文档一致性 | 分块导致术语断裂 | 原生支持整本词典连贯处理 | 需分块但逻辑衔接强 |

典型场景表现(以OED词条“serendipity”为例):

- V1:直译词源(“造词自霍勒斯·沃波尔”),例句生硬(“幸运的机缘巧合”);

- V3:术语精准(保留“coined”直译),但文学性弱;

- R1:文化转译(“机缘与慧眼交织”),韵律感强(四字短语)。

三、OED词典翻译的模型选型与技术路径

首选方案:V3+R1双模型协作流水线

graph LR

A[原始词条] --> B(V3术语骨架提取)

B --> C[预置术语库过滤]

C --> D(R1语境优化)

D --> E[人工核校]

E --> F[术语库同步]

-

阶段分工

- V3-0324负责:

- 批量提取词头、发音、词源(专名直译零误差);

- 生成直译释义/例句骨架(术语错译率≤1%)。

- R1-0528负责:

- 润色例句(如古英语诗歌转译);

- 注入文化注释(如“serendipity”译为“意外之喜”契合中文认知)。

- V3-0324负责:

-

术语控制技术

- 约束生成:加载UMLS/WordNet术语库,强制模型输出一致性;

- 正则预提取:用

(\w+)\s*=\s*正则式锁定词头,避免误译; - 提示词工程:

角色:OED专业译者 规则: 1. 不翻译词头(如“blitzkrieg”保持原文) 2. 词源部分直译人名/地名 3. 例句用“【】”标注文化注释

替代方案:纯R1-0528+人工干预

- 适用场景:预算有限、词条文化负载高(如文学类词典);

- 优化策略:

- 启用

low-temperature=0.3抑制创造性,提升术语准确性; - 配合GalTransl工具自动提取词头生成“不译词典”。

- 启用

四、实操建议:从winn现状到高效工作流升级

-

模型迁移路径

- 立即停用V1,切换至DeepSeek-V3开源版(本地部署,128K上下文免分块);

- 复杂词条调用R1-0528 API(官网价格$0.1/1M tokens,成本可控)。

-

质量保障工具链

工具 功能 适用阶段 GalTransl 自动化术语提取/缓存管理 译前预处理 SDL MultiTerm 云端术语库同步 全流程 EmEditor宏 格式校验(标记丢失检测) 译后质检 -

成本优化技巧

- 简单词条用V3蒸馏模型(如R1-Distill-7B,6G显存可运行);

- 错峰调用API:利用DeepSeek闲置时段(UTC 0:00-6:00)费率降40%。

总结:winn的困境源于早期模型与受限API的组合瓶颈。OED级项目需拥抱MoE架构与强化学习新范式——以V3为“骨骼”确保术语精准,以R1为“血肉”注入语言灵性,辅以术语库硬约束,方可在权威性与表现力间取得平衡。目前DeepSeek-V3已开源,建议优先部署本地版,彻底摆脱分块翻译之痛。

问:本地特别是使用普通家用电脑的个人部署deepseek V3/R1-0528模型需要什么配置环境跟条件?有网友认为不太现实,请评论。

在普通家用电脑上部署DeepSeek V3或R1-0528这类千亿级大模型,确实存在显著挑战,但通过合理的模型选择和技术优化,个人用户仍可有限实现。以下是具体分析与实践路径:

一、全量模型部署:家用电脑几乎不可行

一、全量模型部署:家用电脑几乎不可行

DeepSeek-V3/R1-0528 的原始参数规模为 671B(混合专家架构),需满足以下极限条件:

- 显存需求

- 全精度(FP16)需约 1.3TB 显存,量化后(如 8-bit)仍需 300GB+ 显存。

- 家用显卡(如 RTX 4090 24GB)显存不足 1/10,多卡并联也无法满足(消费级主板不支持 8 卡互联)。

- 内存与存储

- 内存需 512GB+,存储需 300GB+ SSD(仅模型权重)。

- 普通电脑内存通常 ≤64GB,差距悬殊。

- 计算与散热

- 需 64 核服务器级 CPU + 1000W 电源 + 液冷散热,远超家用机箱承载能力。

结论:全量模型需专业数据中心,家用电脑部署“不现实”的观点完全正确。

二、可行方案:蒸馏模型 + 量化优化

二、可行方案:蒸馏模型 + 量化优化

通过 小参数量化版本 和 推理框架优化,普通电脑可运行轻量级模型:

1. 模型版本选择(Ollama 官方推荐)

| 模型 | 显存需求 | 最低配置 | 适用场景 |

|---|---|---|---|

| DeepSeek-R1-1.5B | 2.6GB (FP16) | 4核CPU + 8GB内存 + 无GPU | 聊天机器人、简单问答 |

| DeepSeek-R1-7B | 14GB (FP16) | RTX 3060 (12GB显存) + 16GB内存 | 文本摘要、基础翻译 |

| DeepSeek-R1-14B | 20GB (FP16) | RTX 4090 (24GB显存) + 32GB内存 | 代码生成、逻辑推理 |

2. 关键技术优化

- 量化压缩:

使用 4-bit/8-bit 量化(如 GGUF 格式),显存降至 原大小 25%~50%(例:14B 模型量化后仅需 5-8GB 显存)。 - 推理框架加速:

搭配 Ollama + vLLM 或 Text Generation WebUI,支持 CPU/GPU 混合推理,内存不足时可借用硬盘缓存。 - 分层加载:

使用 HuggingFace Accelerate 的device_map="auto",将模型分块加载至 CPU/GPU/硬盘。

三、普通电脑部署实操指南

三、普通电脑部署实操指南

硬件门槛举例

- 入门级(1.5B/7B 模型):

- CPU:i5/Ryzen 5(4核+)

- 内存:16GB DDR4

- 显卡:RTX 3060(12GB 显存)或核显(纯 CPU 模式)

- 存储:NVMe SSD 500GB

- 进阶级(14B 模型):

- 显卡:RTX 4090(24GB 显存)

- 内存:32GB DDR5

- 电源:850W 金牌

软件工具链

- 框架选择:Ollama(极简命令行)或 LM Studio(图形界面)。

- 模型下载:

# 通过 Ollama 部署量化版 DeepSeek-R1-7B ollama run deepseek-r1:7b-q4 - 内存不足补救:

- Windows:开启虚拟内存(SSD 预留 64GB 空间)

- Linux:使用

swapfile扩展交换分区。

四、“不现实论”的合理性与局限性

四、“不现实论”的合理性与局限性

合理之处

合理之处

- 千亿参数全量模型确实需要超算级硬件,个人用户无法承担。

- 即使成功加载,推理速度可能极慢(如 7B 模型在 CPU 上生成 100 字需 1 分钟)。

局限性

局限性

- 忽略轻量级替代方案:蒸馏模型(如 7B/14B)在文本生成、翻译等任务中性能可达原版 70%。

- 低估优化技术:量化 + 分层加载可使 32B 模型在 24GB 显存设备运行。

总结:理性规划,量力而行

总结:理性规划,量力而行

| 需求场景 | 推荐方案 | 硬件成本 | 性能预期 |

|---|---|---|---|

| 学习/轻量应用 | DeepSeek-R1-7B(4-bit量化) | 5千~1万元 | 满足基础问答、写作 |

| 开发/专业任务 | DeepSeek-R1-14B(8-bit量化) | 1.5万~3万元 | 支持代码生成、报告撰写 |

| 研究/全参数体验 | 租赁云服务器(A100×8) | 100元/小时 | 原版性能,按需付费 |

普通用户推荐从 DeepSeek-R1-7B-Q4 起步,配合 Ollama 部署,体验成本低于 5000 元。若追求更高性能,可关注云服务(如硅基流动,¥1.5/小时)。

技术永无绝对不可能,唯在权衡取舍间 —— 在有限资源下,蒸馏模型与量化技术已为个人打开大模型落地之门。

我不是很清楚,官网推荐的,我也仔细看了表里的两种选择。

代码里这么写:

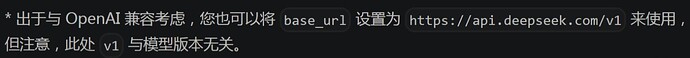

url = “https://api.deepseek.com/v1/chat/completions”

这个url调用的是v3-0324。chat代表deepseek-v3-0324;reasoner代表deepseek-r1-0528。官网API貌似不支持调用旧版模型。

用api搞翻译不是这么整块整块直接塞进去的,这样也不便编辑吧。应该将每个释义和例句都提取出来,一句一译调用api效果比较好,然后再翻译插入原mdx。只能说看了这么多楼,全是ai和api不太熟悉的人在纸上谈兵。

api性能不如官网是常见的事情,核心最优体验让你在官网用才是有助于商业的行为。

以及deepseek不是性价比之选,自二月结束优惠期涨价300%,性价比是显然不如其他模型的(因为人家自己算力都不够,那时候全网爆火官网几乎不可用一直繁忙),而且deepseek幻觉严重、经常不听提示词,那时候起很多人就弃用deepseek了。选gemini2.5-flash性能更强,规范化输出也比较理想。(不过话又说回来,搞个翻译用小参数量的开源模型或者早期廉价模型也没什么关系,翻译也不需要那么强的能力,看经济能力吧)其实不是最近推出了DeepSeek-R1-0528的话,我感觉这公司AI业务都快落后国内外一截了。

syaoranwe/LLM-Price: 大语言模型服务价格汇总

我问过ds,是单句提交好还是整块提交好,回答肯定是整块好。想一下觉得有道理,整块提交能提供上下文,单据不能。你说得对,我也觉得好像回到西晋时代了。

整块提交你怎么做到对应关系?数据处理不头疼?西晋时代听不懂。文字越长,ai越不听话,越不会格式化规范化输出,越短越好的。不要对ai的记忆长度抱希望,现在的推理模型说话容易忘的毛病比之前的模型严重。而且api的记忆功能要比官网差很多,我几乎当成不存在。