最近因《汉语大词典》多版本电子文本同异互校代码调试不顺,心思旁骛,转移到其他关切度稍次要的辞书——《现代日汉双解词典》上。这本上海外教社推出的词典步入新世纪后的第二个十年,终于有修订本面世,较之旧版有大幅度增删的,面目一新。作为国人编纂的一部的词典,不脱窠臼,体例上未有太大的创新,收词体量、问世节点在另外两部五万词以下的双语词典吉教版日汉双解词典和外研版日汉双解学习词典之间。同吉教版词典一样,在释义、例证方面充分发挥“拿来主义”的传统,大量参考(爬录)日语主流辞书,有很多“前辈”珠玉的影子(依个人直观感受,释义大量搬用岩波国语辞典),这点是一大弊窦,却也是一大优点,毕竟论语感、语义的把握,本土学者较之母语专研学者终有一尘之隔,不如就着“旧瓶旧酒”进一步调酿为佳。同吉教版词典不同的是,该书在除了新增补许多新词新义外,在词义中文对译方面更显简练明晰,少了一板一眼的繁琐解释性词义;在例句中文对译方面也更显自然干净,不至于有太多生硬之处。同外研版词典比起来,外教版词典似乎本土化程度更高,根据本土学习者二语习得的语言习惯,在词条详略处理上更胜一筹,对国内日语各等级/水平考试相关范畴的词汇适配度也高(这一点,也体现在我随机抽检了《日本語教育語彙表》五十个词语是否载录于本词典,结果是除了两个复合词、派生词之外,均有收录)。

话分两头,且说我尝试注册火山引擎平台( https://www.volcengine.com)账号,并开通多款模型50万token额度试用,主要用于PDF格式的日汉双语词典内页截图的OCR扫描任务,导出数字化文本。在试用之前,本身对多模态大模型的期望值就不是很高,结果也正如我所料,视觉大模型虽然参数很大,但免不了还是有幻觉产生,整体精度较之“独擅雄风”的扫描全能王这一专用工具还是略嫌逊色(如果把每页扫描的成本也算进去,另外比较性价比的话,那就更显弗如远甚了)。其意义所在,一是,针对扫描王本身的弱项——词典编纂特殊符号的识别,进行补充纠正;二是,模型本身可以设定提示词,对词典文本本身的隐在问题,一定程度上可以摘引出来以供辨正。

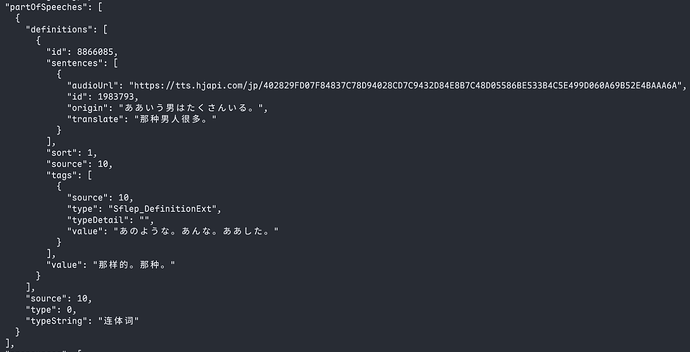

经过各模型同一批次测试截图样张识别质量、效率的比较权衡,最终决选出Doubao-1.5-thinking-vision-pro这一具备深度思考能力的模型作为主用模型,正式开通模型32元1300万token量的资源包。这里要吐槽一下,在试用阶段,据我个人感知,豆包Doubao-1.5-vision-pro(不具备深度思考能力)、Doubao-1.5-thinking-vision-pro、Doubao-Seed-1.6-vision这三款模型在体验平台执行扫描任务时输出文本质量(识别精度)是相当的,在不启用深度思考能力的情况下token数也是相当的。但在正式调用API进行扫校任务时,却发现了几个槽点。一是在不启用深度思考的情况下,Doubao-1.5-thinking-vision-pro、Doubao-Seed-1.6-vision两个模型导出的识别文本都有符号转义问题,部分特殊编纂符号如“↔”“Δ”等以英文命名字符串形式显示,且存在缺失字符缺失,而官方体验窗口则没有此类问题。这就变相着倒逼用户启用深度思考模式以规避符号转义问题,与之同时产生的问题则是token消耗量的增加,取一页一栏计,未启用深度思考模式平均消耗token量两千三四,启用深度思考模式平均消耗token量三千六七(回答内容+推理内容)。二是OCR质量上,似乎也是以官方体验窗口直出的文本为佳,在同参数设定下,同模型千字错误率api调用始终稍稍落后于平台体验。当然,不知道是不是跟我代码调适不当有关。

在这里,也说一下模型选用的一段“前文”。在最初我使用的是扫描全能王和夸克扫描进行词典PDF扫描,但对于双语词典文本的识别,夸克明显有点力不从心,字符错误率奇高,而且词条界限分断也不如扫描王精确。思量再三,决定另外物色第三个称手合用的“兵器”。先是相中魔搭社区的通义千问2.5-VL-72B-Instruct模型,但该模型同火山引擎的Doubao-1.5-thinking-vision-pro模型相比,虽然同为视觉多模态模型,对于用户指令的遵循上却不是那么尽量始终如一严格贴合,三不五时会有错乱,多行词条揉成“一团”,而且多发性某页页首一两段字符“缺失”,令人防不胜防。未免事后校补、调整耽误太多功夫,遂选用豆包模型。

再者,说一下豆包模型OCR文本与扫描全能王OCR文本两相参校时发现的问题,也即词典本身的编写问题。因为日语汉字规范化进程时间跨度很大,该词典修订本编写时所参照的毕竟都是旧版词典,同新近日语公私、官民出版物选词造语倾向选用的汉字难免有出入,如我观察到的“酱”“侠”“啮”“剥”“赞”“阔”等字(此处为输入法打字方便,都用的中文简体汉字)即是这种情况。

末后,一并给到词典OCR工作流框架代码和《现代日汉双解词典》第101~200页内页截图压缩包及OCR文本(含初校文稿),以便有兴趣的坛友可以进行复现。

通过网盘分享的文件:内页截图暨识别文本.zip等2个文件

链接: https://pan.baidu.com/s/1gHjkVUoH8Hz54CkQqE9tjQ?pwd=yuj8 提取码: yuj8

–来自百度网盘超级会员v4的分享